De AI Act is op 8 maart 2024 definitief goedgekeurd door het Europees Parlement. Dit was de laatste horde die de wetgeving moest nemen, nadat de lidstaten al eerder akkoord waren gegaan.

De AI Act is op 8 maart 2024 definitief goedgekeurd door het Europees Parlement. Dit was de laatste horde die de wetgeving moest nemen, nadat de lidstaten al eerder akkoord waren gegaan.

De AI Act is een zeer belangrijke mijlpaal in de regulering van kunstmatige intelligentie in de EU. De wetgeving stelt een kader vast voor wat wel en niet mag met AI, met als doel om burgers te beschermen tegen de risico’s van deze technologie, terwijl innovatie en ontwikkeling worden gestimuleerd.

De wettelijke bepalingen van de AI Act voor hoog-risico groepen (en AI toepassingen en services binnen het HR domein vallen hier binnen) treden in werking in twee fasen:

- 2 december 2024: Vanaf deze datum moeten hoog-risico AI-systemen voldoen aan de eisen van de AI Act. Dit betekent dat ze onderworpen zijn aan strikte veiligheidseisen en dat ze moeten worden goedgekeurd door een conformiteitsbeoordelingsinstantie voordat ze op de markt kunnen worden gebracht.

- 6 maanden later: Na 2 december 2024, dus 6 juni 2025, gelden de eisen van de AI Act ook voor bestaande hoog-risico AI-systemen die al op de markt zijn.

Eisen voor hoog-risico AI-systemen onder de AI Act:

De AI Act stelt strenge eisen aan hoog-risico AI-systemen om de veiligheid, gezondheid en fundamentele rechten van mensen te beschermen. Deze eisen kunnen worden onderverdeeld in de volgende categorieën:

1. Risicobeoordeling en -beheersing:

- Ontwikkelaars en gebruikers van hoog-risico AI-systemen moeten een uitgebreide risicobeoordeling uitvoeren om te identificeren en te beoordelen welke potentiële risico’s het systeem met zich meebrengt.

- Op basis van de risicobeoordeling moeten passende maatregelen worden genomen om deze risico’s te beperken.

2. Technische en organisatorische maatregelen:

- Hoog-risico AI-systemen moeten worden ontworpen en ontwikkeld met behulp van robuuste en betrouwbare technieken.

- Ontwikkelaars moeten passende technische en organisatorische maatregelen nemen om de veiligheid en beveiliging van het systeem te waarborgen, zoals gegevensbescherming, toegangsbeheer en robuuste logboekregistratie.

3. Gegevensbeheer:

- Hoog-risico AI-systemen mogen alleen worden getraind en gebruikt met gegevens van hoge kwaliteit die relevant, representatief en niet-discriminerend zijn.

- Er moeten passende maatregelen worden genomen om de privacy en veiligheid van de gebruikte gegevens te waarborgen.

4. Transparantie:

- Gebruikers van hoog-risico AI-systemen moeten duidelijk worden geïnformeerd over het gebruik van het systeem en de werking ervan. Dit omvat informatie over de mogelijkheden en beperkingen van het systeem, de gebruikte gegevens en de genomen risicobeperkende maatregelen.

- Informatie over het gebruik van hoog-risico AI-systemen in de samenleving moet openbaar worden gemaakt, tenzij dit in strijd is met legitieme belangen, zoals nationale veiligheid of de bescherming van de persoonlijke privacy.

5. Menselijk toezicht en controle:

- Hoog-risico AI-systemen moeten altijd onderworpen zijn aan menselijk toezicht en controle. Dit betekent dat mensen de mogelijkheid moeten hebben om in te grijpen en de werking van het systeem te overschrijven wanneer dat nodig is.

- Beslissingen die door een hoog-risico AI-systeem worden genomen, mogen niet onherroepelijk zijn en mensen moeten de mogelijkheid hebben om deze beslissingen te betwisten.

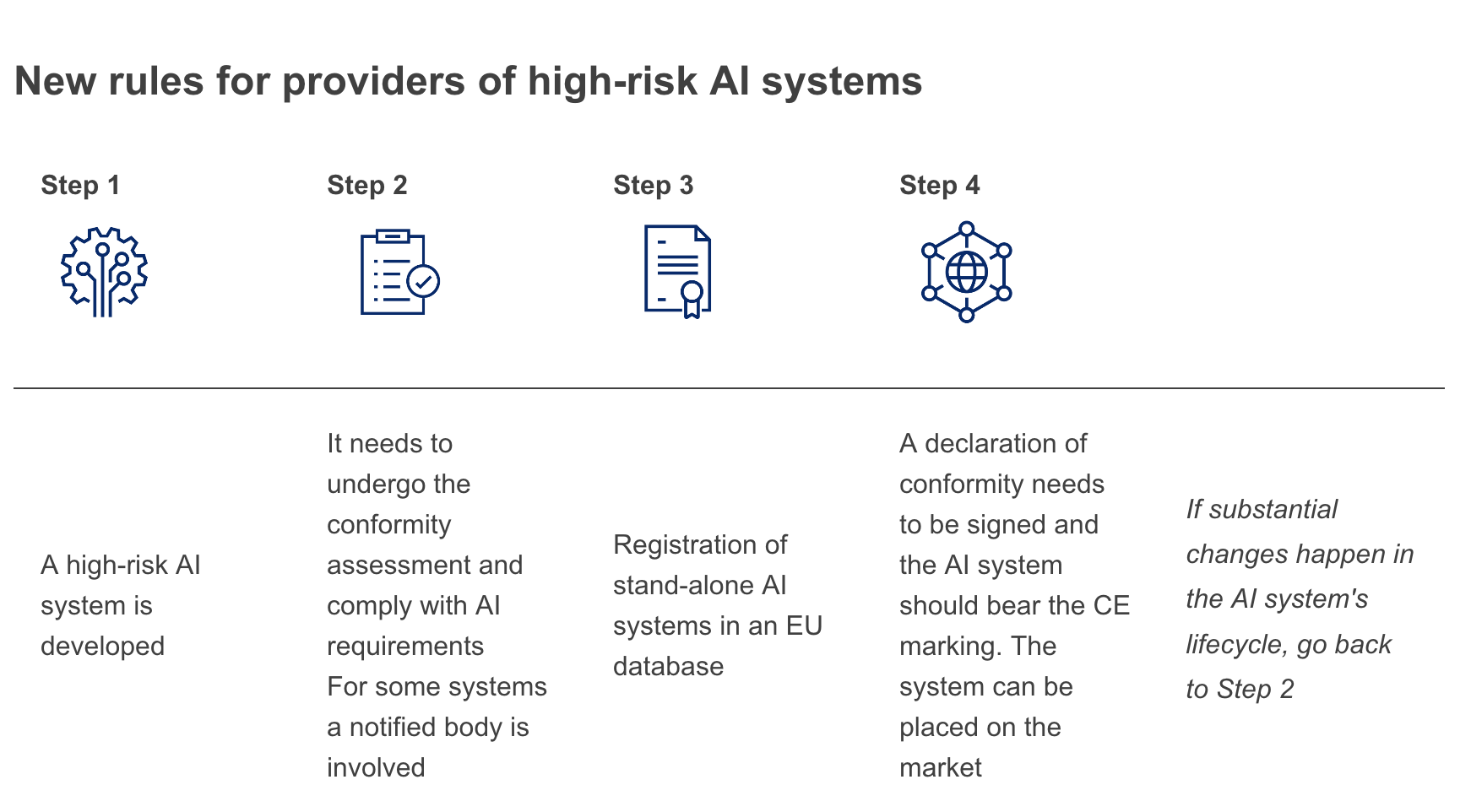

6. Conformiteitsbeoordeling:

- Hoog-risico AI-systemen moeten worden beoordeeld door een conformiteitsbeoordelingsinstantie om te controleren of ze voldoen aan de eisen van de AI Act.

- Afhankelijk van het risiconiveau van het systeem zijn er verschillende conformiteitsbeoordelingsprocedures van toepassing, variërend van zelfverklaringen tot uitgebreide controles door een onafhankelijke instantie.

7. Markttoezicht en handhaving:

- De naleving van de AI Act wordt gehandhaafd door de nationale autoriteiten van de EU-lidstaten.

- De Europese Commissie heeft de bevoegdheid om boetes op te leggen tot 6% van de wereldwijde jaaromzet of 30 miljoen euro, naargelang wat het hoogste is, voor niet-naleving van de AI Act.

En nee, een AI-bedrijf dat zich in de hoog-risico groep bevindt en zich niet houdt aan de GDPR, kan niet voldoen aan de eisen van de hoog-risico groep van de AI Act.

De AI Act stelt strenge eisen aan de verwerking van persoonsgegevens door AI-systemen, en deze eisen zijn grotendeels gebaseerd op de beginselen van de GDPR. Dit betekent dat AI-bedrijven die hoog-risico AI-systemen willen ontwikkelen en gebruiken, zich in de eerste plaats moeten conformeren aan de GDPR.

De GDPR bevat onder meer de volgende belangrijke beginselen die relevant zijn voor AI-systemen:

- Rechtmatigheid, doelbinding en beperking van de verwerking: Persoonsgegevens mogen alleen worden verwerkt voor welbepaalde, uitdrukkelijke en gerechtvaardigde doeleinden die relevant zijn voor de context waarin de gegevens worden verwerkt. De verwerking moet adequaat, relevant en beperkt zijn tot wat nodig is met het oog op de doeleinden waarvoor de gegevens worden verwerkt.

- Minimale gegevensverwerking: Persoonsgegevens moeten adequaat, ter zake dienend en beperkt zijn tot wat nodig is met het oog op de doeleinden waarvoor ze worden verwerkt.

- Opslagbeperking: Persoonsgegevens mogen niet langer worden bewaard dan nodig is voor de doeleinden waarvoor ze worden verwerkt.

- Integriteit en vertrouwelijkheid: Persoonsgegevens moeten worden verwerkt op een wijze die een passende beveiliging garandeert van de persoonsgegevens, met inbegrip van een passende bescherming tegen ongeoorloofde of onrechtmatige verwerking en tegen ongeautoriseerde toegang, verlies, vernietiging of beschadiging, door middel van passende technische of organisatorische maatregelen.

- Verantwoordingsplicht: De verwerkingsverantwoordelijke is verantwoordelijk voor de naleving van de beginselen inzake persoonsgegevensverwerking en kan aantonen dat aan deze beginselen is voldaan.

AI-bedrijven die zich niet aan deze beginselen houden, lopen het risico op boetes van de toezichthoudende autoriteit, schadeclaims van betrokkenen en reputatieschade.

En dan is er nog dit. Hoog-risico AI systemen moeten blijkbaar ‘gecertificeerd’ gaan worden. Als het nieuw op de markt komt, maar ook als er een substantiële wijziging is opgetreden. Dat gaat vast heel veel gefriemel opleveren rondom het woord substantieel…: