Gisteren klaagde ik over het gebrek aan journalistieke duiding dat NRC verschafte bij slimme product placement van Indeed. Indeed mag ik niks kwalijk nemen. Toen ik nog verticalverkoper was deed ik precies hetzelfde. Dat hoort bij je werk.

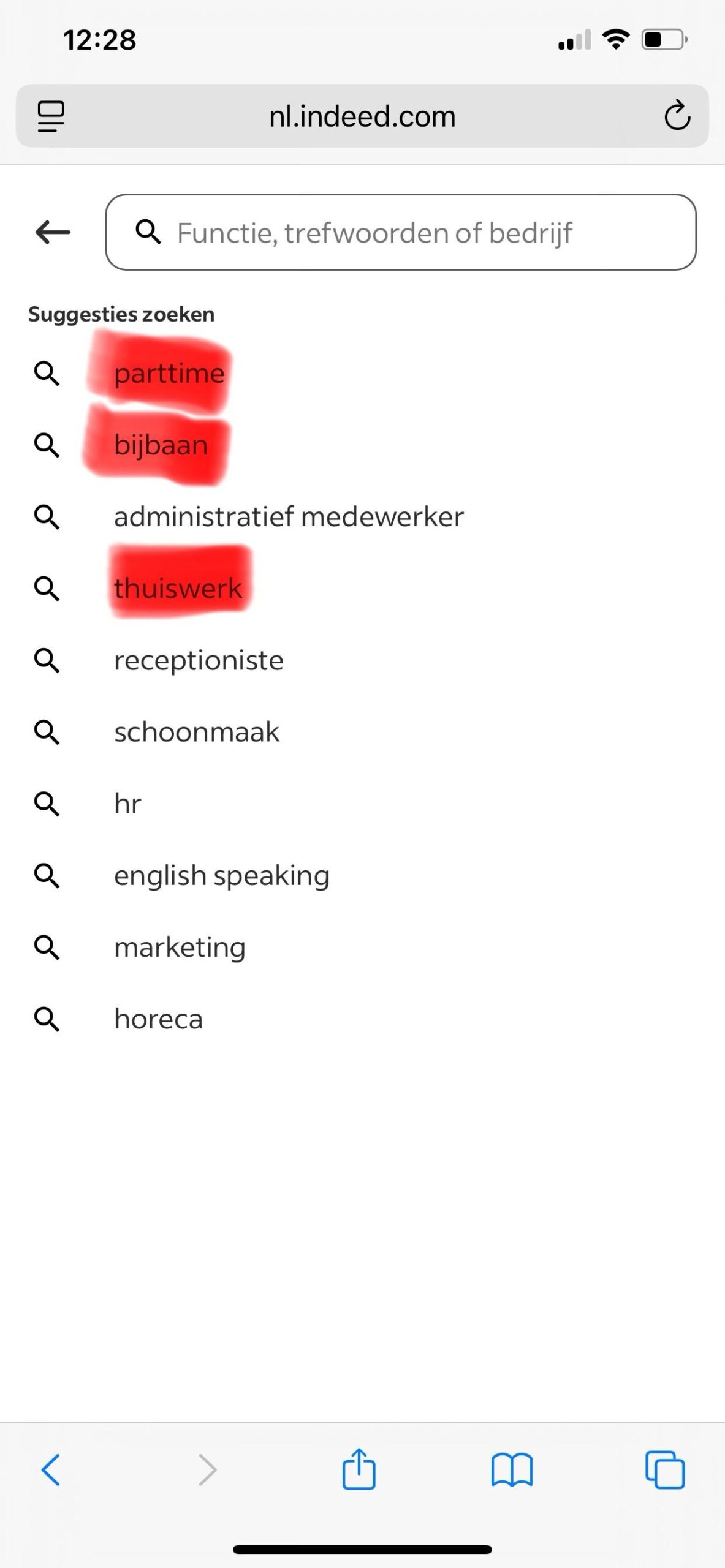

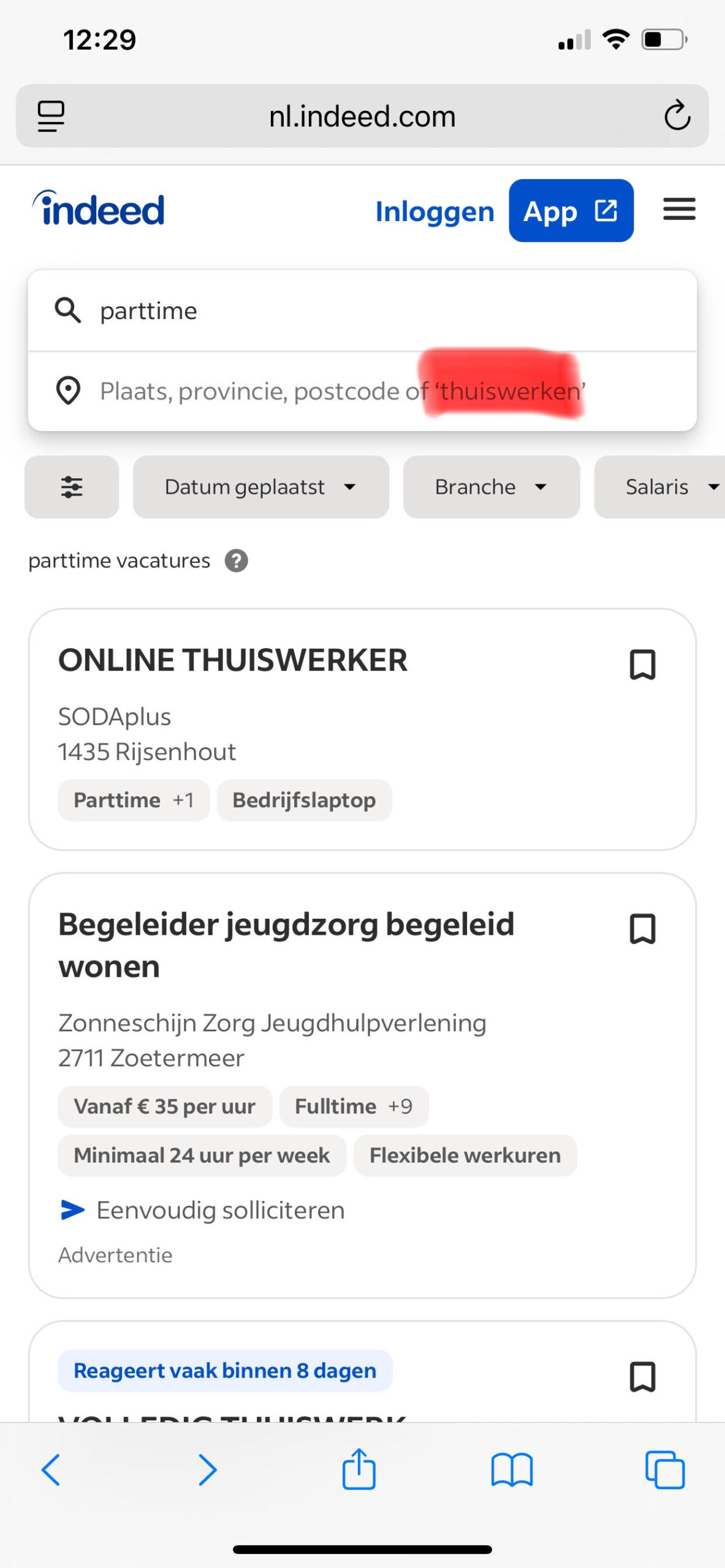

NRC kan ik het wel kwalijk nemen. Want als Indeed cijfers geeft over wat mensen invoeren in een zoekveld, dan moet je natuurlijk wel even controleren dat het zoekveld geen suggesties toont. En dat heeft NRC niet gedaan. Kijk maar, Marc Drees heeft het fraai in beeld gebracht. Indeed toont suggesties.

Ja, zo lust ik er nog wel een paar.

(meer…)