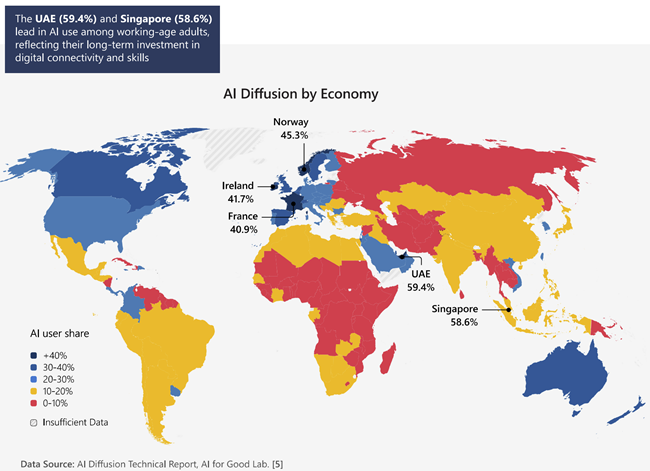

wat is er aan de hand?

op artificialanalysis.ai worden al enige tijd alle ai topmodellen de kleren van het lijf gevraagd, de antwoorden zijn geturfd en weergegeven in onafscrollbare hoeveelheden grafieken

https://artificialanalysis.ai/models/gemini-3-1-pro-preview

sinds vandaag is aan die grafieken iets opvallends te zien, het Google icoontje staat helemaal aan de linkerkant, kijk maar, Google is nu dus de beste

(meer…)