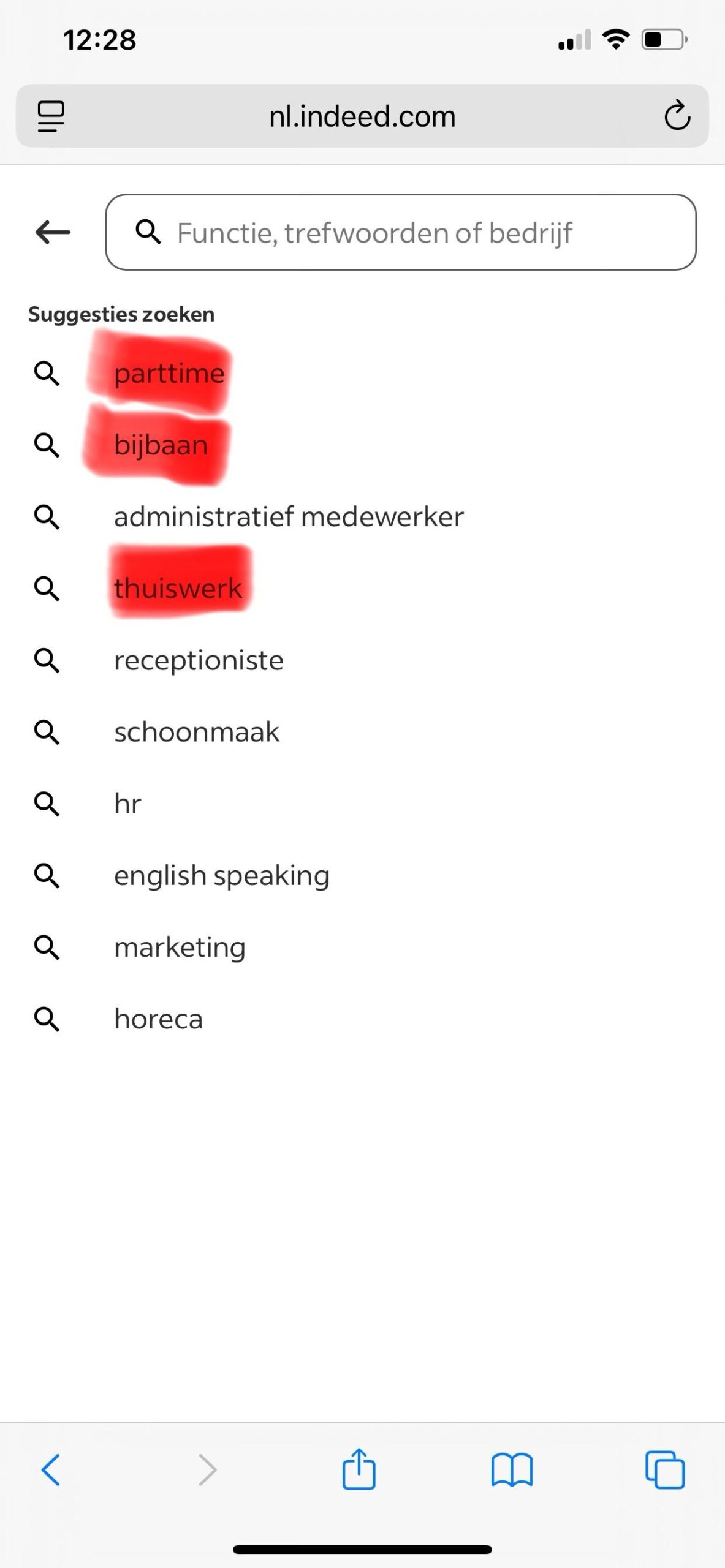

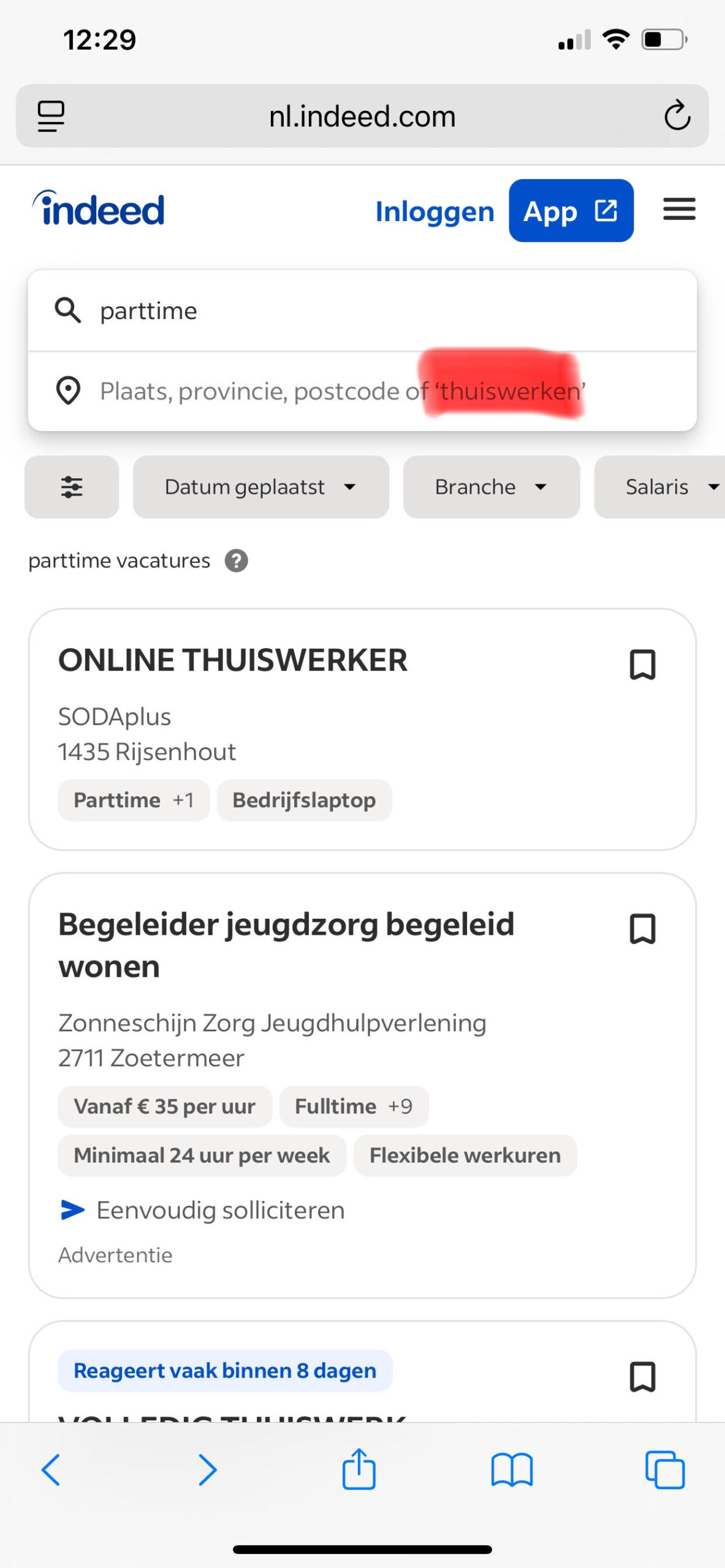

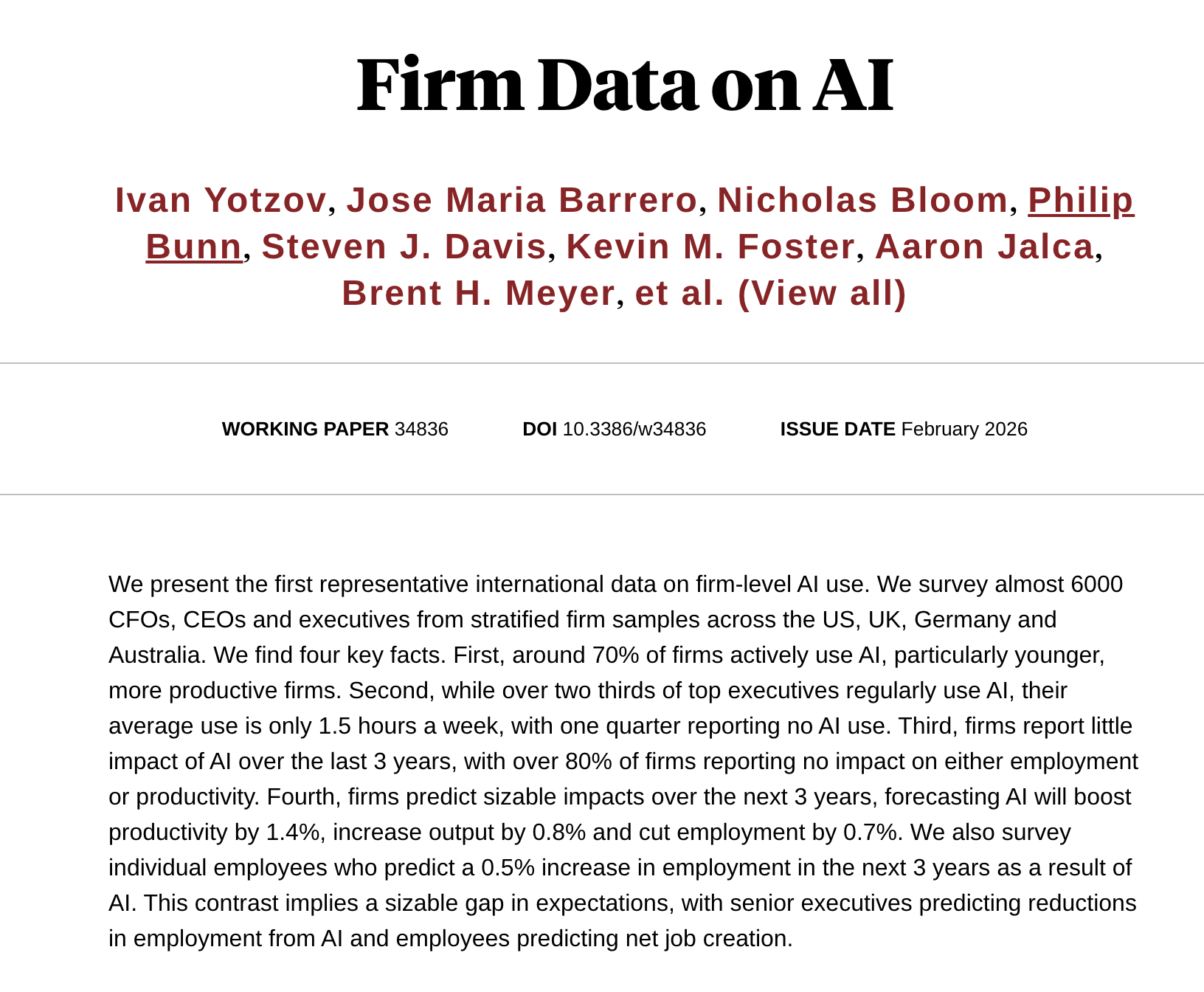

LinkedIn heeft een privacy policy. En met dit gegeven is de gemiddelde Functionaris Gegevensbescherming (FG) afdoende tevreden gesteld. Maar is dat terecht? Of laat ik de vraag anders formuleren: Wat vindt u van de dataverwervingspraktijken van Indeed c.s. (denk aan Stepstone, Totaljobs, ZipRecruiter, Seek)? Of liever gezegd, vindt u het een goed idee dat Indeed c.s. informatie van het sollicitatieproces binnen haar eigen systemen vastlegt om “zoekresultaten te verbeteren” zonder dat de sollicitant hier van op de hoogte is gesteld? Als u dat een goed idee vindt, welterusten en tot nooit. Als dat niet zo is, lees dan vooral verder. Disclaimer: ik ben niet verantwoordelijk voor enig mentaal of fysiek ongemak bij de lezer na lezing van deze blog posting.

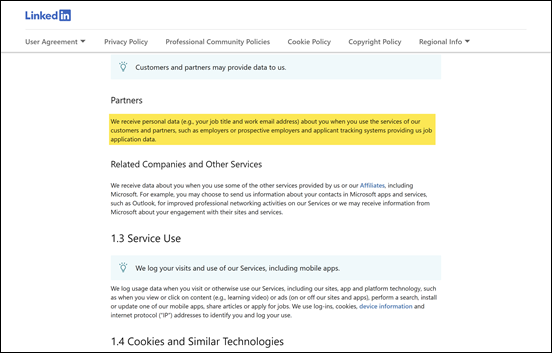

LinkedIn zegt in haar privacy verklaring onder meer het volgende:

Privacy Policy, 1.2 Data from Others, Partners – LinkedIn